推しアイデア

貴重な情報資源であるオープンデータを利用して、なんの得にもならないアプリをつくったところ

貴重な情報資源であるオープンデータを利用して、なんの得にもならないアプリをつくったところ

おもしろそう

postGISを使用した緯経度からの範囲指定検索の実装

この作品は、2025年9月に行われた "Progateハッカソン powered by AWS & Project LINKS" での出場作品です。

こんな経験はありませんか?

長い旅程に危険はつきもの。 「Go島てる」を使用することで、過去のデータから自分の通る経路上でどんな事故があったかを分析し、あるかもしれない可能性に気付き、理由もなく恐怖することができます。

Project LINKSで公開されている「自動車運送事業事故データ」の02_jikohoukokusyo.csv「自動車運送事業の事故報告書データ(ファイル02)」を使用しました。

https://www.geospatial.jp/ckan/dataset/links-jidousyaunsoujigyoujiko-2024

(データ処理は下に記載があります)

2.ふたつのマーカーを設置し「シミュレーション開始」をクリックすると、過去の事故データがDBからクローリングされ、表示されます。 画像は試しに500件くらい表示してみたやつ。

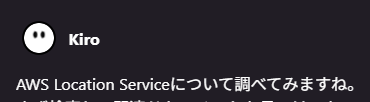

アプリとインフラに分けて紹介します。

前提として、全てのリソースを aws でホスティングしています。

※間違ってる可能性があります

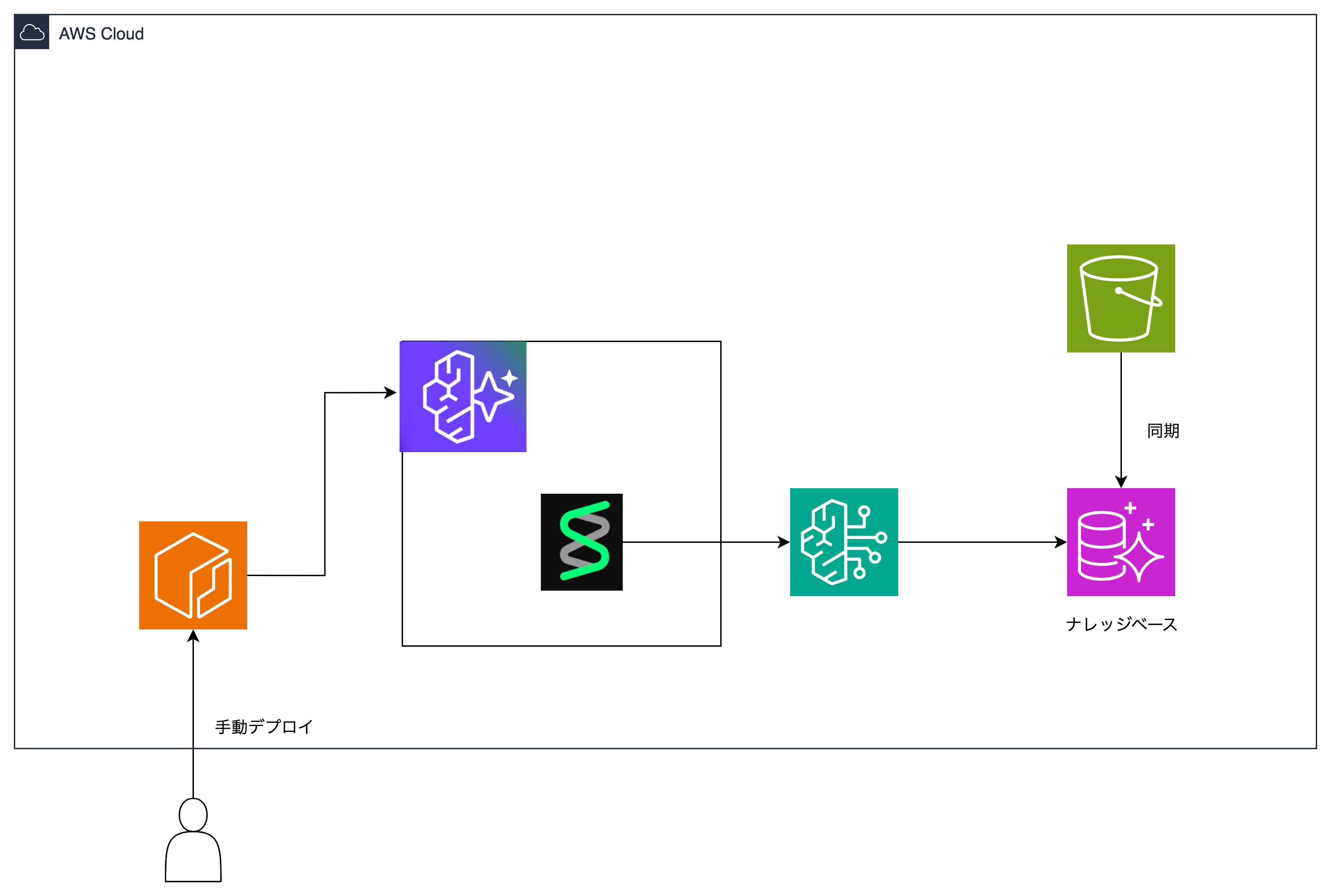

使用したオープンデータには、事故の情報が約60カラムに渡って詳細に記載されていました。

Amazon Bedrock経由でモデルに各行のデータの一部をプロンプトとして渡し、各事故データに対し「タイトル」と「概要」を生成しました

Sagemakerのnotebookインスタンス上で処理を行いS3にcsvを保存し、EC2からpsqlで、RDSのデータベースにアクセスしクエリを叩いて、S3に保存した加工済みデータをテーブルへ挿入しました

SELECT aws_s3.table_import_from_s3( '{table_name}', '', '(format csv, header true)', aws_commons.create_s3_uri( '{bucket_name}', '{file_path}', '{region}' ) );

参考: Amazon S3 から RDS for PostgreSQL DB インスタンスにデータをインポートする

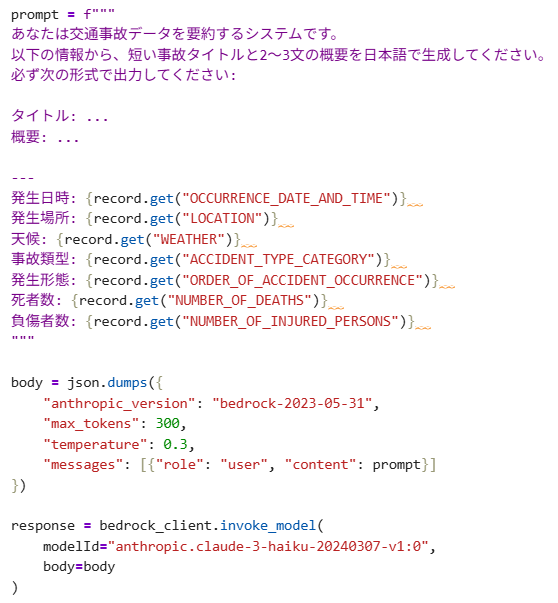

serverlessを使うことでコスト削減が・・・ できませんでした(本当に申し訳ございません)

できませんでした(本当に申し訳ございません)

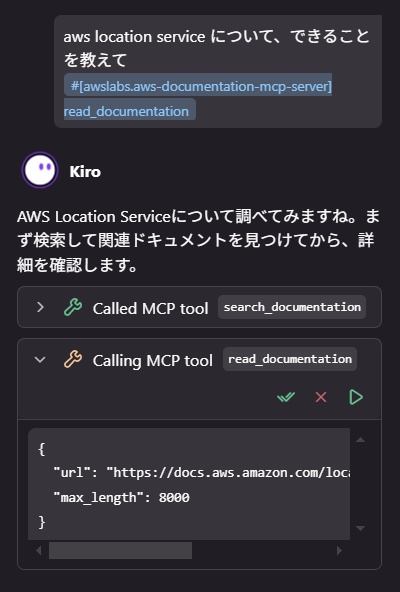

今回は aws を触るので、aws 公式の documentation MCP を使用しました。 https://awslabs.github.io/mcp/servers/aws-documentation-mcp-server/

AI Agent に登録しておくことで、最新の情報を参照してくれるようになります。

※触ったけどハッカソン向きじゃないな......と思ったので、途中から触るのをやめてます

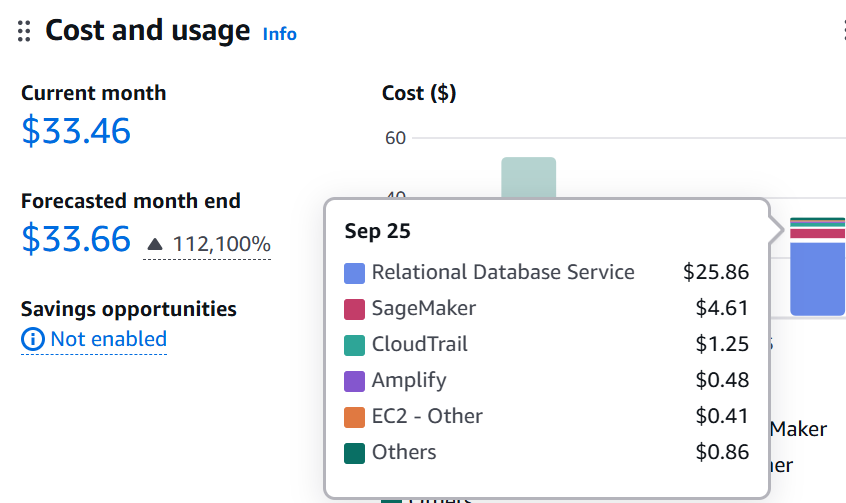

なんと、だいぶ前に waitlist に登録していた Kiro がハッカソン前日に来ていました。やった~

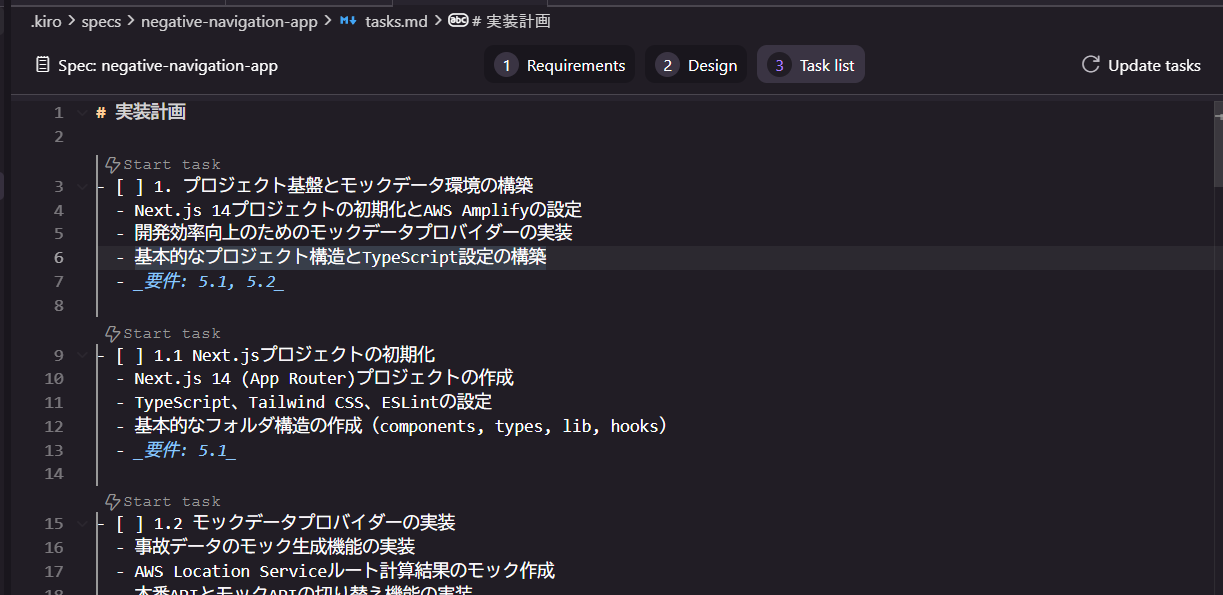

Kiro は Amazon が提供する AI IDE です。ほかの AI IDE のように Vibe Coding もできますが、その強みは Kiro spec にあります。 詳しい説明は 公式記事 に任せますが、簡単にまとめると

といったフローで開発を行います。こうすることで AI が要件をどのように解釈しているかが開発者からもモニタリングできるほか、これまで人間が行ってきた「要件定義」「設計」のフローを新たに AI Agent が肩代わりできるようになり、開発速度の向上が見込めます。

画面はこんな感じ。それぞれ「要件定義(Requirement)」「設計(Design)」「タスク(Task List)」と書き下してくれるので、これからなにをするかがハンドリングしやすいです。

ちなみに、VSCode ベースなので以降も楽でした。(wsl からの起動だけちょっと工夫が必要)

ちなみに応答待機中は Kiro くんがキョロキョロします。かわいいね。